1. 산업 전반의 AI 혁신 (AI Transformation Across Industries)

1.1 AI Transformation

: 헬스케어, 금융 서비스, 자율주행차를 포함한 모든 산업에서 AI 기반 혁신중

- 의료 분야 AI : 기반 신약 개발, 의료기기 혁신, 암세포 실시간 분석 가능

- 금융 분야 AI : 사기 탐지, 로보 어드바이저, 가상 금융 자문 등

- 자동차 산업 AI : 자동차 제조업체의 설계 시각화, 엔지니어링 시뮬레이션, 자율주행 등

- 생성형 AI : 자연어 처리, 콘텐츠 생성, 멀티모달 인텔리전스 고도화로 컴퓨터 산업 혁명

1.2 헬스케어 AI

: AI로 인한 헬스케어 산업의 변화: 신약 개발(Drug discovery) 및 의료기기 분야 혁신

1) 생물학적 시스템 모델링, 질병 연구 및 타겟 약물 발견

2) AI/컴퓨팅 기반 인실리코(In silico)1 신약 개발 : 분자 생성 및 구조 예측, 가상 스크리닝, 예측적 분자 동역학(Predictive molecular dynamics) 등을 구현

3) 센서/로봇 기반 실험실 자동화 : 고처리랑 선별검사(HTS, high-throughput screening) 및 약물 조합 (Drug formation)

1.3 금융 AI

: 금융 서비스 영역에서 AI 활용 사례

1) 알고리즘 기반 로보 어드바이저(Robo-advisor)를 활용하여 투자 포트폴리오 선정/관리

2) 지능형 영상 분석 기반 위협 탐지(Threat detection) 및 ATM 보안 강화

3) 딥러닝 기반 사기 탐지(Fraud detection) 정확도 제고 및 실시간 알림 기능 제공

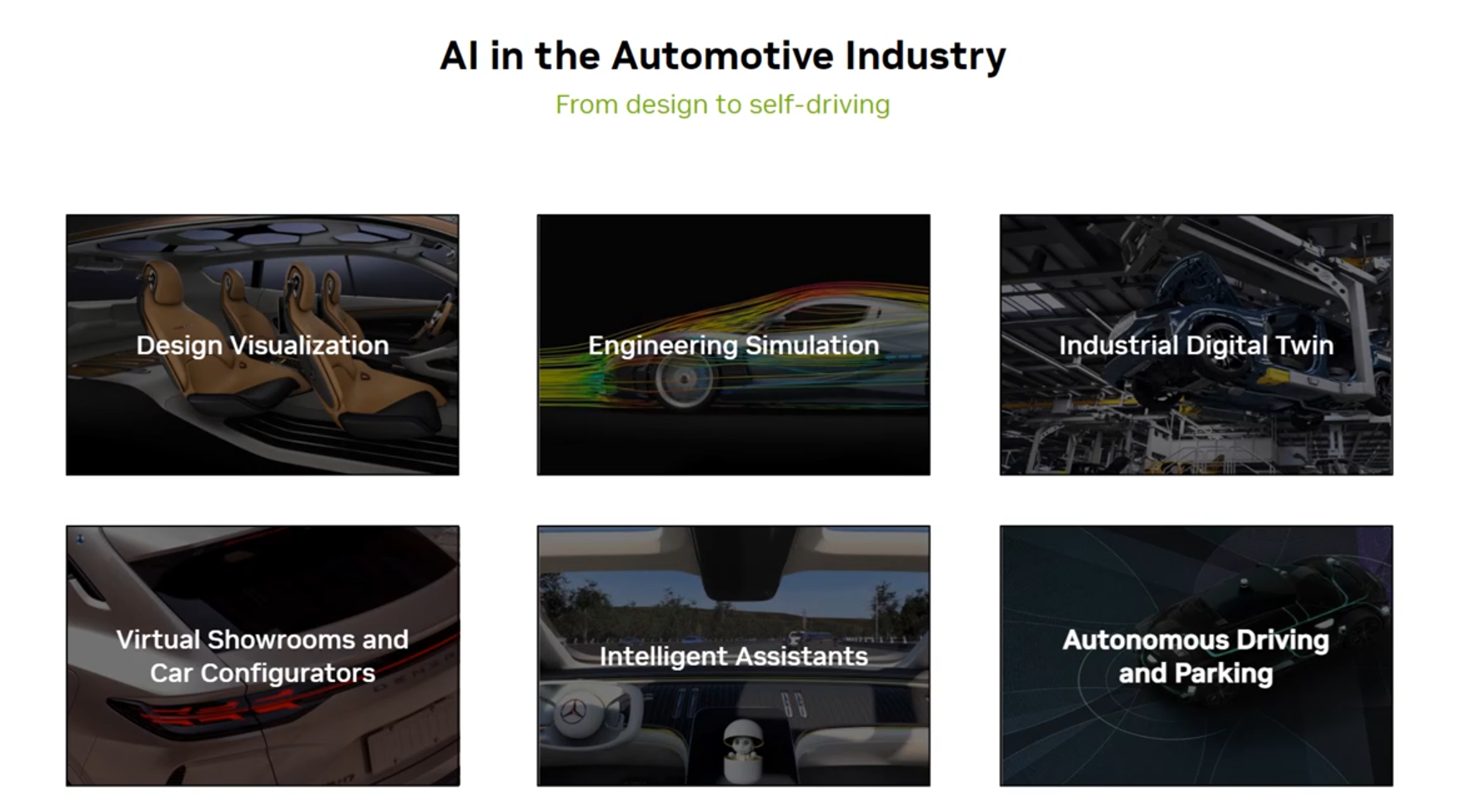

1.4 자동차 산업 AI

: 설계부터 자율주행 자동차까지 AI 활용 중

1) 설계 시각화 및 엔지니어링 시뮬레이션

2) 산업용 디지털 트윈(Industrial digital twins) 및 가상 쇼룸

3) 지능형 보조장치, 자율주행 및 주차 시스템 개발

2. AI 소개

2.1 Key Message

- AI 워크플로우 4단계 : 데이터 준비 > 모델 학습 > 최적화 > 배포/추론(deployment/inference)

- AI 모델 개발 시 도전 과제 : 폭발적으로 증가하는 모델 크기/복잡성, 다양한 AI 모델 아키텍처에 대한 요구, 성능과 확장성, AI를 실제 환경에 적용(Production)하는 과정

- 엔비디아 AI 플랫폼 : 상용 AI(Porduction AI)를 위한 엔드투엔드 S/W 플랫폼

- AI 진화의 주요 이정표 : 강력한 GPU 등장, 대규모 데이터셋의 이용 가능성, 학습 알고리즘의 발전

2.2 AI 워크플로우 (AI workflow)

- 종종 ML2 workflow나 DS3 workflow로 불림

- 데이터 과학자, ML 엔지니어, AI 실무자가 AI 모델을 개발, 학습, 배포 및 유지관리 하는데 따르는 일련의 작업 및 프로세스

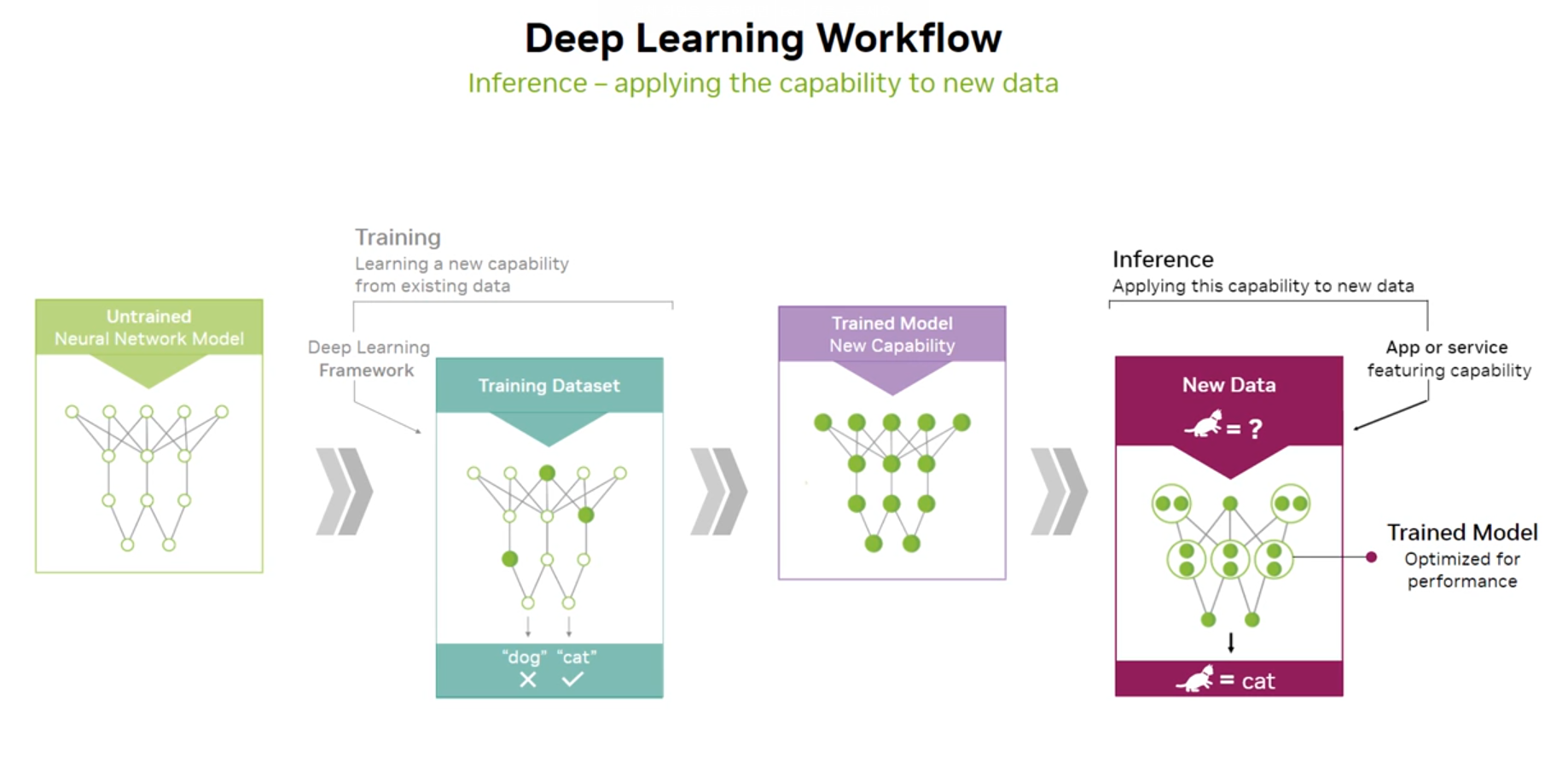

2.3 딥러닝 워크플로우 (Deep Learning workflow) 작동 원리

- 신경망(neural network) 기반 데이터 학습

- 기존 데이터 기반 새로운 능력 학습

- 학습된 모델 최적화

- 학습된 능력을 새로운 데이터에 적용

2.4 기업이 AI를 도입할 때 직면하는 주요 과제

- 폭발적으로 증가하는 모델 크기/복잡성 (Exploding model sizes and complexity)

- 다양한 AI 모델 아키텍처에 대한 요구 (Diverse AI model architectures)

- 성능과 확장성 (Performance & scalability)

- AI를 실제 환경에 적용하는 과정 (AI to production)

2.5 AI 영역별 주요 차이점 (Key differences in the realm of AI)

- 인공지능(AI) : 대규모 데이터셋의 활용 (Large datasets)

- 머신러닝(ML) : 정교한 통계적 방법론 사용 (Sophisticated statistical methods)

- 딥러닝(DL) : 신경망(Neural networks)과 트랜스포머(Transformer) 모델 적용

- 생성형 AI (generative AI) : 데이터 분석, 예측, 학습 및 새롭고 고유한 콘텐츠 생성 능력

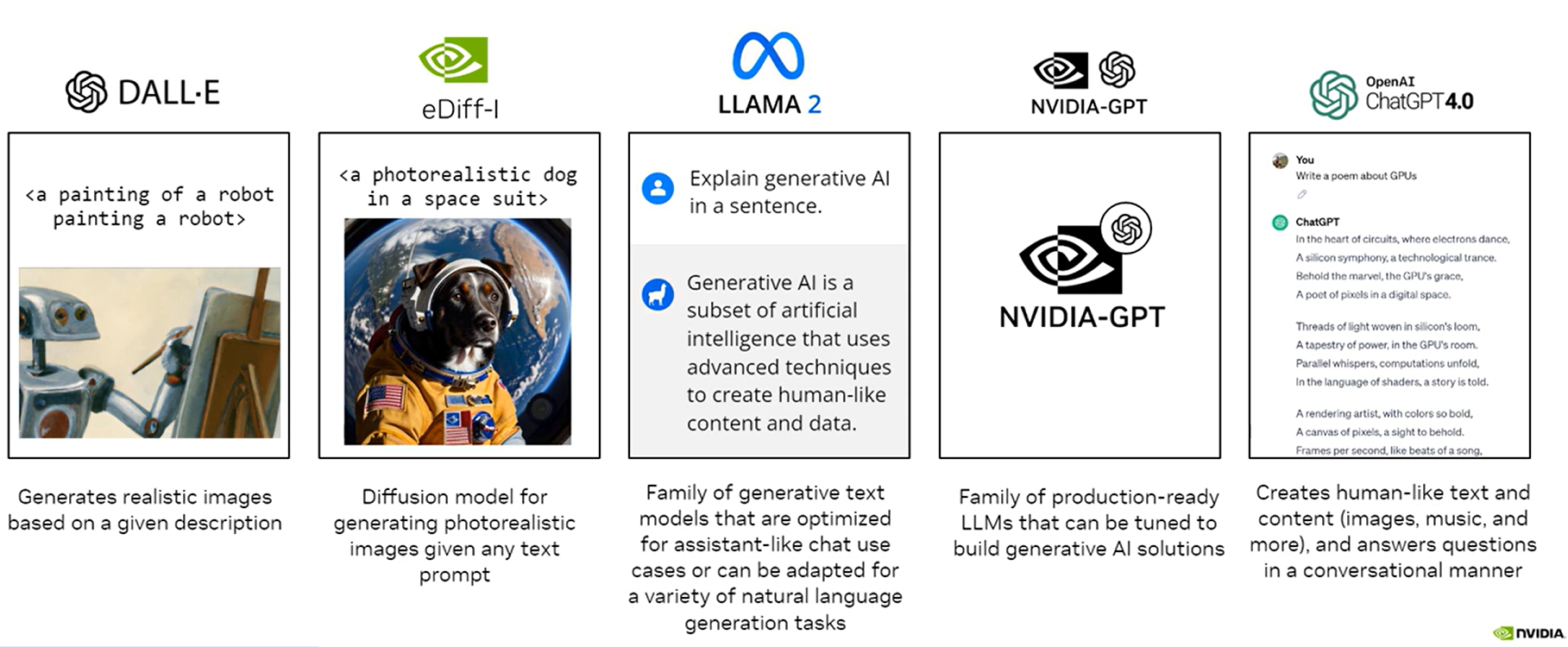

3. 생성형 AI 개요 (Generative AI)

3.1 Key message

- 생성형 AI (Generative AI) : 입력 데이터의 패턴을 학습하여 사람과 유사한 콘텐츠를 생성하는 고급 기술을 사용하는 AI의 하위 분야

- 대규모 언어 모델 (LLM)4 : 생성형 AI는 LLM을 활용하여 입력 프롬프트를 기반으로 텍스트를 생성함

- 파운데이션 모델 (Foundation Models) : 파운데이션 모델은 생성형 AI 시스템의 개발과 진화의 기초가 되는 모델로, 방대한 비지도 데이터셋에서 학습됨

- 생성형 AI 기반 기업 과제 해결 방안 : 생성형 AI 서비스 활용(Generative AI as a Service), 사전 학습된 모델 미세 조정(Fine-Tuning), 맞춤형 모델 구축(Custom Models)

3.2 파운데이션 모델 (Foundation Model)

- 생성형 AI 시스템의 개발과 진화를 위한 기초가 되는 모델

- 일반적으로 비지도 학습(Unsupervised Learning) 방식으로, 방대한 비지도 데이터셋(Massive Unlabeled Datasets)을 학습한 신경망(Neural Networks)으로 구성

3.3 대규모 언어 모델 (LLMs, Large Language Models)

- 인간과 유사한 텍스트를 생성하도록 설계된 고급 AI 시스템

- 트랜스포머(Transformer)라는 특화된 신경망을 활용하여 텍스트 데이터 내 패턴과 관계를 파악

3.4 GPU는 생성형 AI에서 어떻게 사용되나?

- 생성형 AI에서 대규모 모델 학습/실행에 GPU 활용

- 성능/속도 향상, 효율성 및 확장성 제공

4. GPU로 AI 가속화

4.1 Key message

- GPU 역사 : 1970년대부터 픽셀 데이터를 처리하는 데 사용, 처리 능력은 시간에 따라 급격히 향상

- GPU 아키텍처 (GPU Architecture) : 최적의 기능 수행을 위한 특화 메모리, 코어, 캐시 메모리를 갖추고 있음

- GPU 가속 (GPU Acceleration) : 계산 집약적인(Coupmute-intensive) 기능을 실행하는데에는 GPU를 사용하고, 나머지 코드는 CPU에서 실행되도록 설계된 방식

- GPU 서버 시스템 : 고성능 컴퓨팅(high performance computing), 병렬 처리(parallel processing), 워크로드 최적화(workload optimization)를 통해 복잡한 계산을 가속화하기 위해 설계된 특수 컴퓨터 시스템

- GPU vs. CPU

- GPU : 고도로 병렬화된 작업 실행에 최적화

- CPU : 일반적 컴퓨팅 작업 및 복잡한 논리 처리에 더 적합

4.2 GPU의 역사

- 1970년대 컴퓨터 등장 이후, 픽셀 데이터 처리를 위해 특화된 전자회로 사용

- 시간이 지남에 따라 GPU의 처리능력 급격히 향상 → 이미지가 포토리얼리스틱(Photorealistic)해짐에 따라 더욱 발전

4.3 GPU 아키텍처 컴포넌트

- GPU 코어 (GPU Cores)

- 캐시 메모리 (Cache Memory)

- GPU 전용 메모리 (GPU-Specific Memory)

4.4 컴퓨터 시스템에서 GPU의 주요 역할

- 고도로 병렬화된 작업 수행

4.5 CPU vs. GPU

- CPU : 범용 컴퓨팅 (General-pirpose computing)과 복잡한 논리 처리(Complex logic)위해 설계

- GPU : 고도의 병렬 처리 (High parallel processing) 능력에 최적화

| 구분 | CPU | GPU |

| 특징 | - 순차 작업 (serial tasks)에 최적화 - 복잡한 논리 처리 및 제어에 적합 |

- 병렬 작업 (parallel tasks)에 최적화 - 대규모 데이터와 그래픽 처리, AI 연산에 적합 |

| 강점 | - 매우 빠른 클럭 속도 (fast clock speeds) - 매우 큰 메인 메모리 (large main memory) - 소수의 스레드 (thread)가 매우 빠르게 실행 가능 - 대형 캐시(large caches)를 통한 지연 시간 최적화 (latency optimized) |

- 훨씬 더 많은 연산 자원 (compute resources) - 병렬성을 통한 지연 시간 허용 (latency-tolerant) - 높은 성능/와트 비율 (high performance/watt) - 높은 대역폭 메인 메모리 (high bandwidth main memory) - 높은 처리량 (high throughput) |

| 약점 | - 상대적으로 낮은 메모리 대역폭 (low memory bandwidth) - 낮은 성능/와트 비율 (low performance/watt) |

- 낮은 스레드 단위 성능 (low per-thread performance) - 상대적으로 낮은 메모리 용량 (relatively low memory capacity) |

4.6 GPU 서버 시스템이란

- GPU를 탑재한 특화된 컴퓨터 시스템

- 고성능 컴퓨팅 (High performance computing), 병렬 처리 (Parallel processing), 워크로드 최적화 (Workload optimization)을 통해 복잡한 계산을 가속화하도록 설계됨

4.7 GPU 기반 AI 워크로드 실행 시 장점

- GPU는 AI 모델이 요구하는 복잡한 명령 세트(complex instruction sets)를 실행하도록 설계됨

- 증가하는 데이터와 AI 모델 크기에 필요한 연산 능력을 제공함

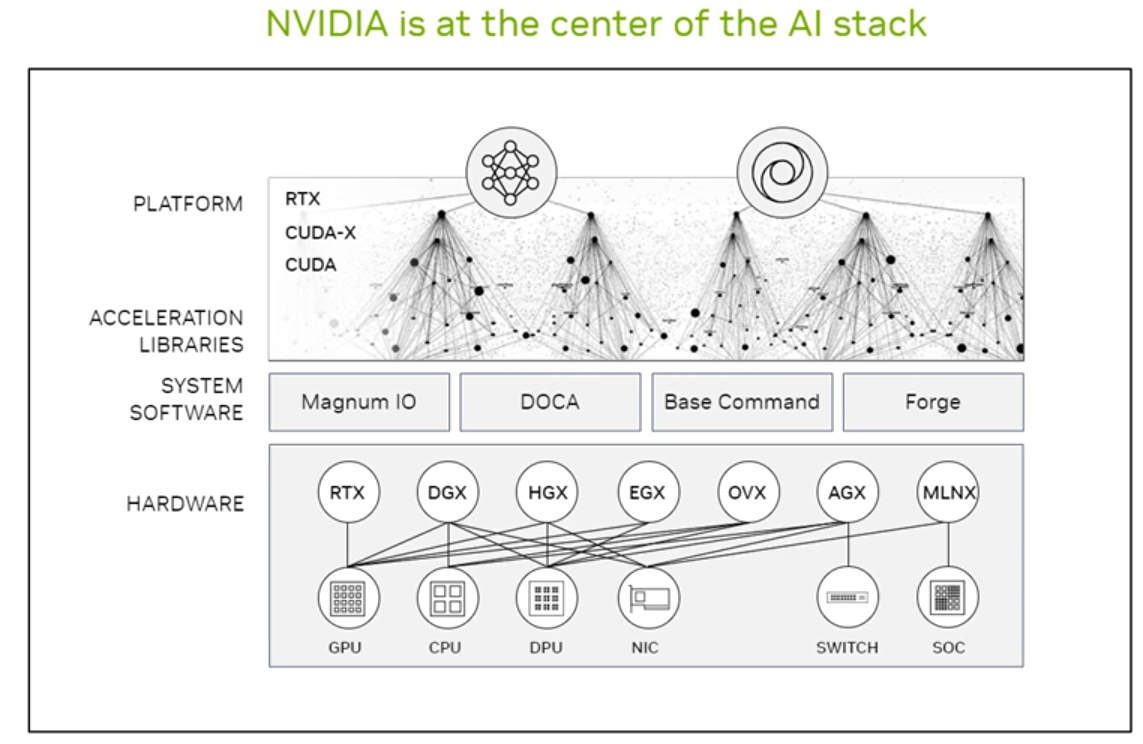

5. NVIDIA AI 소프트웨어 에코시스템

5.1 Key message

- NVIDIA AI Software : 엔비디아 AI 소프트웨어 생태계는 vGPU Foundation, 딥러닝을 위한 프레임워크 및 소프트웨어 스택 개요 포함

- NVIDIA AI Enterprise : 50개 이상의 프레임워크와 사전 학습된 모델을 포함한 종단 간(end-to-end) AI 소프트웨어 모음

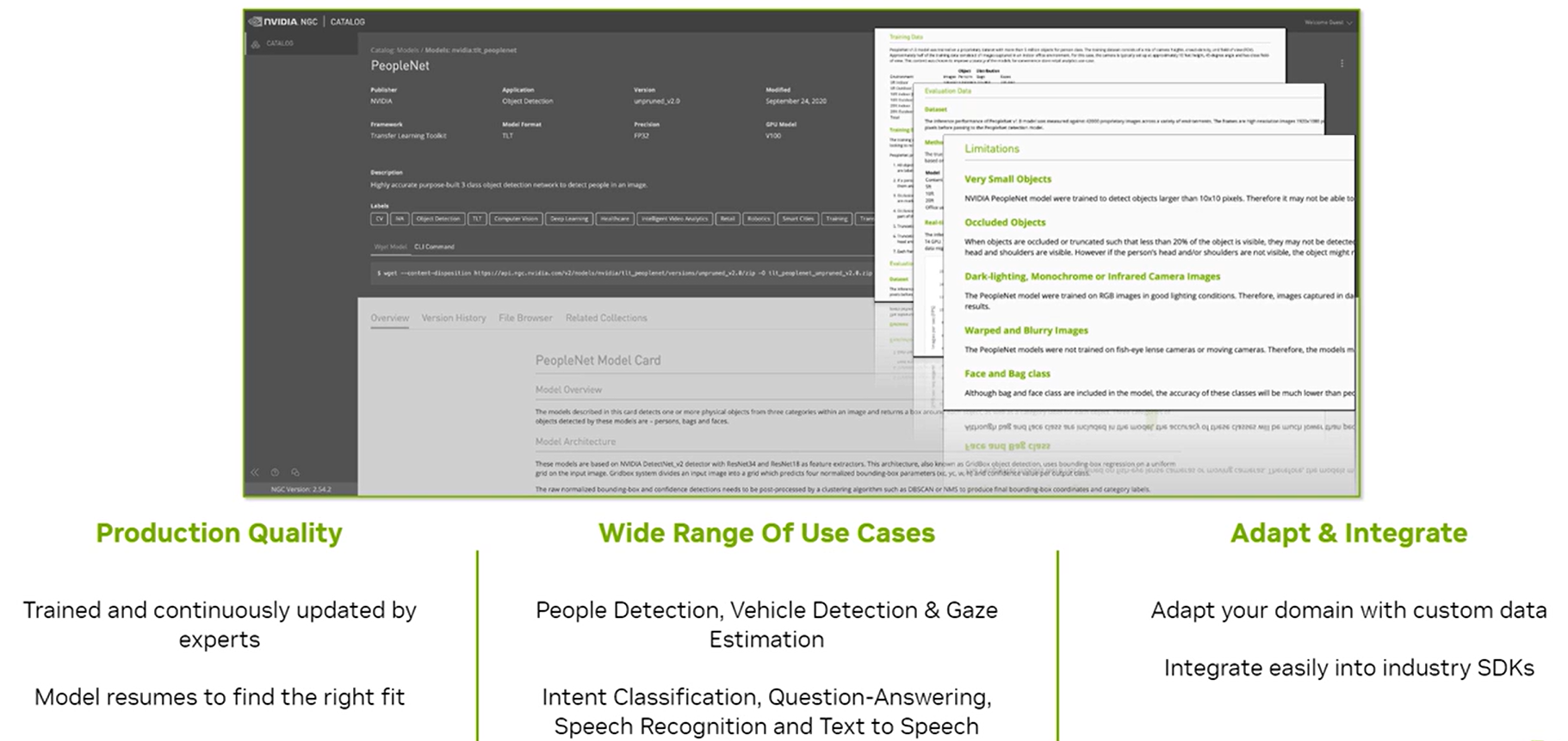

- NGC Catalog : AI와 HPC 소프트웨어를 위한 GPU 최적화 허브. 컨테이너, 사전 학습된 모델, Helm 차트를 포함함

- AI Workflows : AI 결과를 신속히 도출할 수 있도록 지원하는 사전 구성된 참조 어플리케이션(Prepackaged reference applications)

5.2 vGPU란

- 가상GPU(Virtual GPU)의 약자로 모든 시각적 워크로드(Visual Workload)에 GPU가속을 제공하는 AI 기반 기술

5.3 GPU 가상화의 이점

- 베어메탈 성능 (Bare-metal performance)

- 인사이트와 도구 제공 (Insights and tools)

- 비즈니스 연속성 및 워크로드 균형 (Business continuity & workload balancing)

- 자원 공유 및 활용도 향상 (Resource sharing & improved utilization)

- 인프라 및 데이터 보안 (Infrastructure & Data security)

- 운영 관리 (Operation management)

5.4 머신러닝/딥러닝 프레임워크 (ML/DL Frameworks)

- 머신러닝(ML) 및 딥러닝(DL) 프레임워크는 고수준 프로그래밍 인터페이스를 통해 머신러닝 모델과 딥러닝 신경망(Deep neural networks)을 설계, 학습, 검증하기 위한 기본 구성 요소

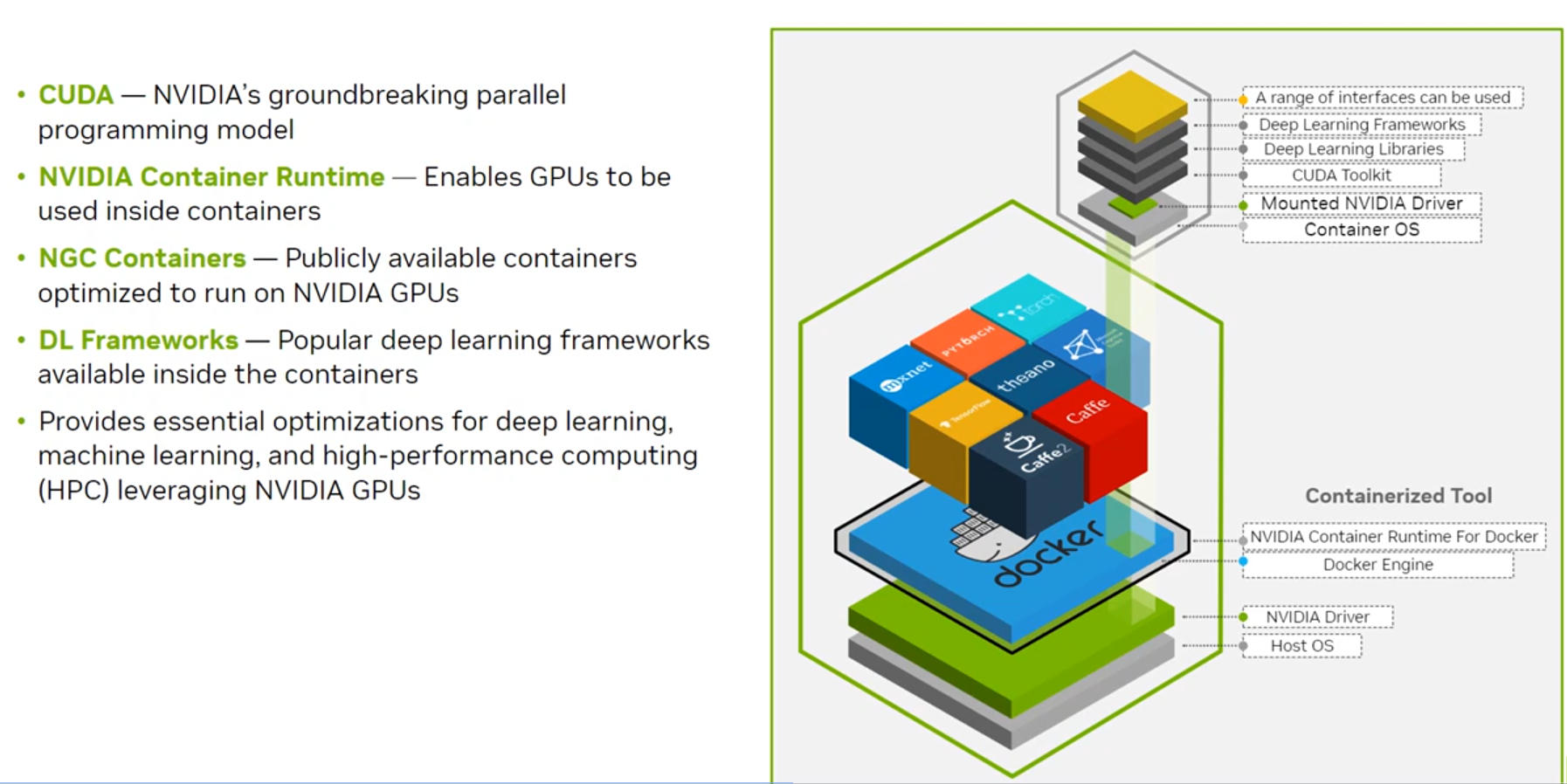

5.5 엔비디아 딥러닝 소프트웨어 스택

- CUDA : 엔비디아의 획기적인 병렬 프로그래밍 모델

- NVIDIA Container Runtime : GPU가 컨테이너 내부에서 사용될 수 있도록 지원

- NGC Containers : 엔비디아 GPU에서 실행되도록 최적화된 공개용 컨테이너

- 딥러닝 프레임워크 (DL Framework) : 컨테이너 내부에서 사용할 수 있는 인기 있는 딥러닝 프레임워크

- NGC Catalog : https://catalog.ngc.nvidia.com/

5.6 엔비디아 AI Enterprise

- 50개 이상의 프레임워크와 사전 학습된 모델을 포함하는 첨단 AI 플랫폼의 기반이 되는 소프트웨어 계층

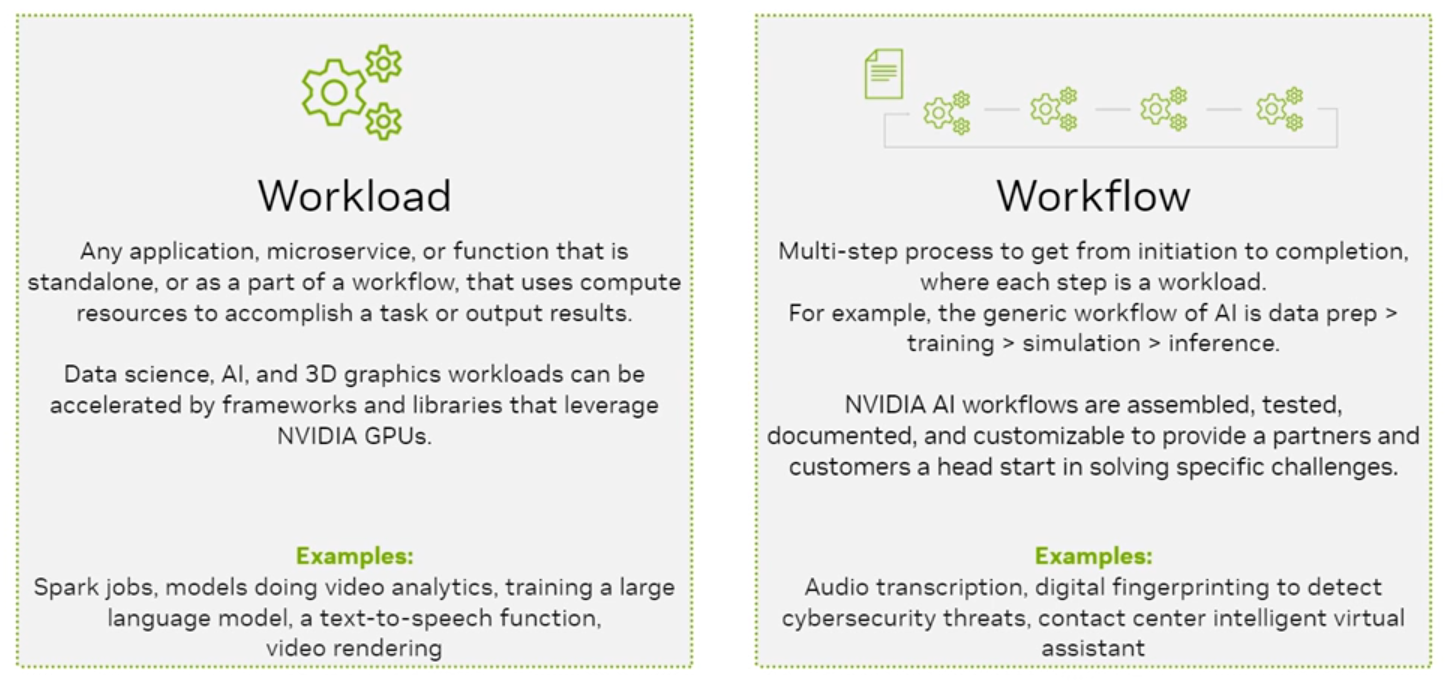

5.7 엔비디아 AI 워크플로우

- AI를 활용하여 비즈니스를 신속하게 자동화 할 수 있도록 설계된 사전 구성된 참조 어플리케이션(Prepackaged Reference Application)

- 이를 통해 AI 솔루션 개발 및 배포 비용 절감 가능

| 항목 | Workload | Workflow |

| 정의 | 어플리케이션, 마이크로서비스 또는 기능이 작업 수행이나 결과 출력을 위해 컴퓨팅 자원을 사용하는 것 | 시작부터 완료까지 여러 단계를 거치는 프로세스로, 각 단계는 워크로드로 구성됨 |

| 특징 | - 독립적이거나 워크플로우의 일부로 동작 - 데이터 과학, AI, 3D 그래픽 작업을 가속화함 |

- 다중 단계 프로세스 - 각 단계가 워크로드로 구성됨 - AI 작업은 데이터 준비 > 학습 > 시뮬레이션 > 추론으로 진행 |

| 활용 기술 |

NVIDIA GPU를 활용하는 프레임워크와 라이브러리 | NVIDIA AI 워크플로우 (조립, 테스트, 문서화 및 맞춤화 가능) |

| 예시 | - Spark 작업 - 비디오 분석 모델 - 대규모 언어 모델 학습 - 텍스트-음성 변환 기능 - 비디오 렌더링 |

- 오디오 글로 옮기기(Trnascription) - 사이버 보안 위협 탐지를 위한 디지털 지문 인식 - 컨택트 센터 지능형 가상 비서 |

6. 데이터 센터 및 클라우드 컴퓨팅

6.1 Key message

- AI Infrastructure : 컴퓨팅(Compute), 스토리지(Storage), 네트워킹(Networking) 구성 요소 포함됨. 가속화된 시스템을 통해 AI 학습 및 추론에 필요한 계산 능력 제공

- 에너지 효율성 (Energy Efficiency) : AI 인프라에서는 속도와 지속 가능성의 균형이 중요함. GPU가 에너지 효율성에서 선두를 차지하고 있음

- 클라우드 컴퓨팅 (Cloud Computing) : 가속 컴퓨팅 성능은 클라우드로 확장될 수 있으며, 이를 통해 운영 비용(OPEX)을 최소화하고 ROI(투자 수익) 극대화 가능

- 인프라 관리 (Infrastructure Management) : AI 인프라 관리에는 프로비저닝(Provisioning), 모니터링(Monitoring) 및 워크로드 관리(Workload Management)가 포함됨. 이를 통해 정보에 기반한 의사결정을 지원함.

- 오케스트레이션 및 스케줄링 (Orchestration & Scheduling) : 오케스트레이션과 작업 스케줄링은 프로비저닝 및 배포를 자동화하고, 워크로드를 효율적으로 관리하는 데 중요한 역할을 함.

6.2 AI workload의 호스팅 환경

- AI 워크로드의 호스팅 환경에는 데이터센터와 클라우드가 포함됨

- 컴퓨팅(Compute), 스토리지(Storage), 관리 노드(Management Nodes)는 네트워크를 통해 연결되어 데이터 센터를 구성함.

- 가속 컴퓨팅의 성능은 클라우드로 확장될 수 있음

6.3 AI 데이터 센터 구성요소

- 컴퓨팅 플랫폼(Compute Platforms) : 가속화된 시스템은 컴퓨터 진화의 다음 단계로, AI 학습(Training) 및 추론(Inferencing)을 위한 계산 능력 제공

- 네트워킹(Networking) : AI 인프라의 중추 역할

- AI를 위한 스토리지(Storage) : AI 워크로드를 위해서는 고속 스토리지 접근(High-Speed Storage Access) 필수

6.4 AI 데이터 센터를 관리하고 모니터링하기 위한 요건과 방법

- 인프라 프로비저닝 (Infrastructure Provisioning)

- 자원 모니터링 (Resource Monitoring)

- 워크로드 관리 (Workload Management)

- 오케스트레이션 (Orchestration) & 작업 스케줄링 (Job Scheduling) : 프로비저닝 및 배포 자동화와 워크로드 관리를 위해 중요한 역할

| 오케스트레이션 | 스케줄링 |

| 컨테이너 기반 | 작업을 컴퓨트 노드에 할당 |

| 프로비저닝 및 배포 자동화 | 작업 실행 및 모니터링을 위한 프레임워크 제공 |

| 로드 밸런싱 (Load Balancing) | 대기 중인 작업 큐 관리 |

| 마이크로서비스를 위해 설계됨. AI에 맞게 적용됨. | 우선순위 큐, 선점 등 고급 스케줄링 기능 내장 |

| 고급 스케줄링 기능을 위한 추가 '메타 스케줄러' 필요 |

(source : 코세라-엔비디아)

'Biusiness Insight > AI · Data Science' 카테고리의 다른 글

| [NVIDIA] AI 인프라 및 운영 - ③ AI 운영 (2) | 2024.12.24 |

|---|---|

| [NVIDIA] AI 인프라 및 운영 - ② AI 인프라 (2) | 2024.12.23 |

| [Google Cloud] Vertex AI 활용 Prompt Design (0) | 2024.07.28 |

| [Google Cloud] Vertex AI Gemini API 및 Python SDK 실습 (0) | 2024.07.27 |

| [Google Cloud] Vertex AI Studio 및 API 사용 설정 (1) | 2024.07.27 |